La guerra automatizada que desgarra Gaza.

En medio de un conflicto que ha causado miles de víctimas civiles, emergen denuncias sobre el uso de sistemas avanzados de inteligencia artificial (IA) por parte de Israel para identificar y bombardear objetivos en Gaza con una precisión letal que raya en la inhumanidad.

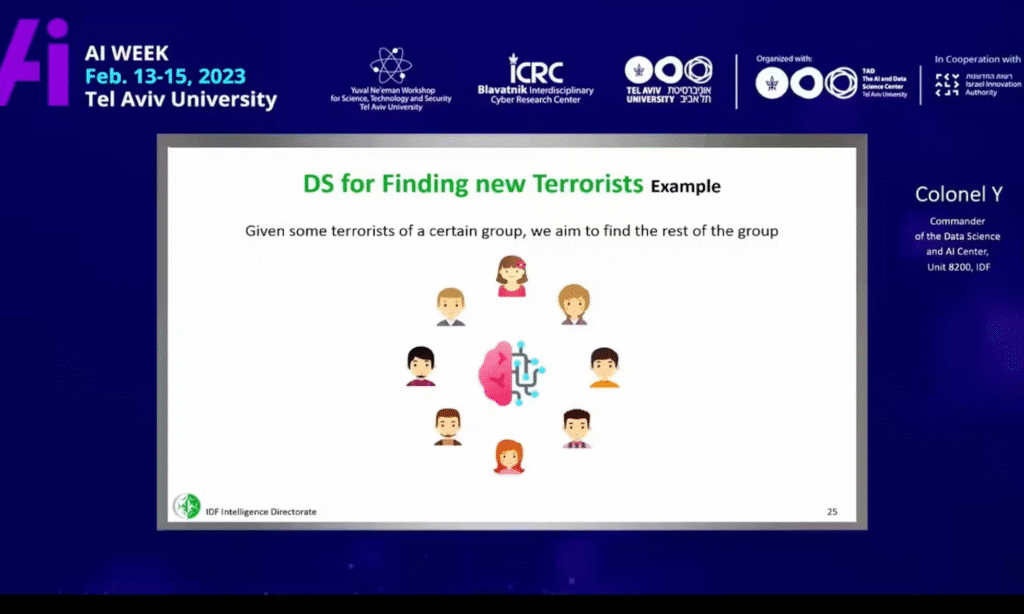

Según informes recientes, Israel ha implementado varias plataformas de IA, como Habsora y Lavender, que analizan datos satelitales, cámaras de vigilancia y bases de datos masivas para seleccionar automáticamente objetivos relacionados con grupos militantes y civiles palestinos.

Estos sistemas no solo aceleran la toma de decisiones, sino que permiten la emisión de listas diarias de objetivos, multiplicando exponencialmente las operaciones bélicas respecto a métodos humanos previos.

El sistema “Lavender”, en particular, mantiene un archivo con decenas de miles de hombres palestinos catalogados como presuntos miembros de organizaciones como Hamás o la Jihad Islámica, recomendando ataques individuales muchas veces sin supervisión humana directa.

Investigaciones señalan que este método ha provocado miles de muertes civiles, con un alarmante porcentaje de falsos positivos.

Además, el uso de la IA en la planificación de ataques aéreos y la localización en tiempo real de objetivos durante horas nocturnas ha sido criticado por expertos en derechos humanos y expertos en derecho internacional.

La falta de transparencia en los algoritmos y la “ilusión de precisión matemática” que generan, junto al elevado número de víctimas colaterales, ha desatado fuertes acusaciones de violaciones graves, que incluyen posibles crímenes de guerra y genocidio.

Organismos internacionales y defensores de los derechos humanos alertan que Gaza se está convirtiendo en un “laboratorio” para esta guerra tecnológica, en la que la automatización y el desdén por la vida humana permiten un nivel de violencia y destrucción sin precedentes.

Mientras la comunidad internacional observa con creciente preocupación, la tragedia de miles de familias palestinas continúa, con un enemigo invisible que no solo es humano, sino también una máquina implacable.

Israel ha implementado sistemas de IA para identificar y atacar objetivos durante sus campañas militares en Gaza. Las herramientas más mencionadas son:

🔹 “Lavender”

- Reportado por, con fuentes dentro del ejército israelí.

- Utilizada para marcar a 37.000 hombres palestinos como posibles combatientes con base en criterios algorítmicos.

- El sistema recomendaba ataques con escasa o nula verificación humana.

- Se admitió que se toleraban “muertes colaterales de hasta 15 o 20 civiles por objetivo” en muchos casos.

🔹 “Gospel” (Habsora)

- IA que analiza imágenes, señales y datos para generar hasta 100 objetivos por día, según el mismo informe.

- Confirmado por analistas militares israelíes y por investigaciones de The Guardian

🔹 “Where’s Daddy?”

- Apodo interno del ejército israelí a una táctica que aprovecha el análisis de presencia nocturna de presuntos combatientes en sus hogares para atacar cuando están con sus familias.

⚖️ ¿Es esto legal? ¿Viola el derecho internacional?

- Organizaciones como Human Rights Watch, Amnistía Internacional, y expertos de la ONU han advertido que:

- El uso de IA sin supervisión humana podría violar el principio de distinción entre civiles y combatientes.

- También puede violar el principio de proporcionalidad.

- Hay riesgo de crímenes de guerra si se demuestra que hubo ataques indiscriminados.

Adicionalmente, The Guardian también investigó un sistema de IA tipo ChatGPT creado por la Unidad 8200, entrenado con cerca de 100,000 millones de palabras provenientes de comunicaciones interceptadas en árabe. Su objetivo: responder consultas sobre personas vigiladas, facilitando la identificación de blancos en Gaza.

Gaza ha sufrido más de 44,000 muertos desde 7 de octubre de 2023. Plataformas como “Gospel”, “Lavender” y “Where’s Daddy?” permitieron una aceleración sin precedentes: de unos 50 objetivos anuales, se pasó hasta a 100 diarios y miles de recomendaciones en semanas.

Estas herramientas han sido vistas como productos para exportar: empresas israelíes del sector militar buscan venderlas a terceros países, extendiendo el problema a nivel global.